Ollama 作为一个开源且极具易用性、能够在本地运行的大语言模型框架,可使用户在自身服务器上极为轻松地部署和运行各类语言模型。本文将详尽介绍如何在 Ubuntu Server 22.04 上部署 Ollama 模型框架。

一、准备工作

1. 服务器环境:务必确保已安装 Ubuntu Server 22.04 系统,且服务器能够正常联网并且网络支持访问Github等平台。

2. 硬件要求:为使 Ollama 能够顺畅运行,强烈建议服务器至少配备 8GB 以上内存,同时拥有具备一定计算能力的 CPU。若有 GPU,则需要额外配置系统环境。

二、安装依赖项

1. 更新系统:

在终端中输入以下命令,更新 Ubuntu 系统的软件包列表以及已安装的软件包。

sudo apt updatesudo apt upgrade -y2. 安装必要的软件包:

Ollama 运行需要一些基础的软件包支持,包括curl、build-essential等。通过以下命令进行安装。

sudo apt install curl build-essential -y3. 安装 Go 语言环境:

Ollama 是使用 Go 语言开发的,因此必须在服务器上安装 Go 语言环境。可通过以下步骤进行安装。

首先,下载 Go 语言的安装包

可从 Go语言官方网站获取最新的安装包链接,此处以 1.20.4 版本为例。

curl -OL https://go.dev/dl/go1.20.4.linux-amd64.tar.gz解压安装包至/usr/local目录。

sudo tar -C /usr/local -xzf go1.20.4.linux-amd64.tar.gz配置 Go 语言的环境变量

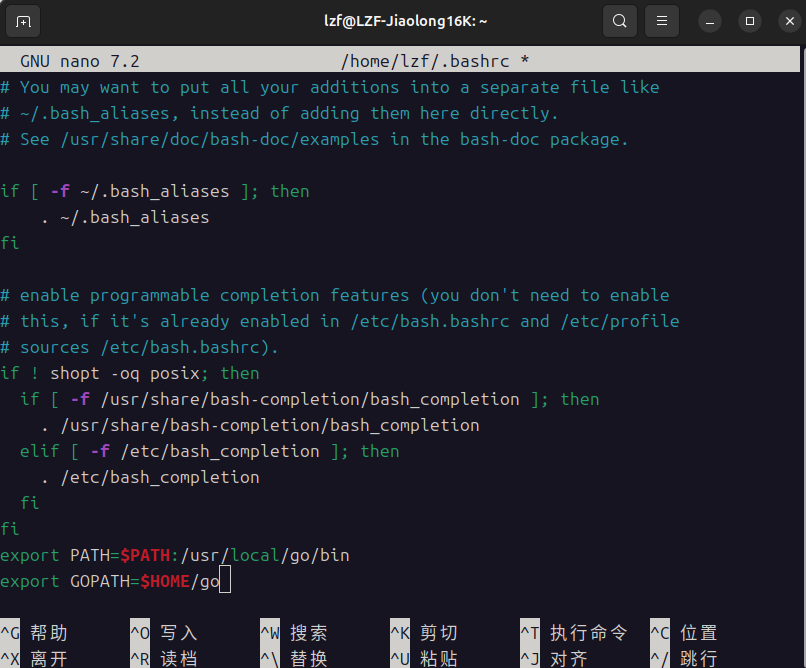

打开~/.bashrc文件,在文件末尾添加以下两行。

export PATH=$PATH:/usr/local/go/bin

export GOPATH=$HOME/go

使环境变量生效

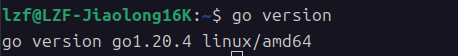

source ~/.bashrc验证 Go 语言是否安装成功

在终端中输入go version,若输出版本信息,则说明安装成功。

三、安装 Ollama

1. 下载 Ollama 安装脚本:

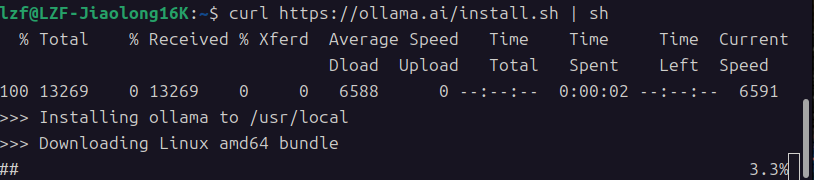

在终端中输入以下命令,下载 Ollama 的安装脚本

curl https://ollama.ai/install.sh | sh如果存在无法连接等问题,请检查网络联通性

可以尝试Ping一下github.com自测

2. 启动 Ollama 服务:

安装完成后,可使用以下命令启动 Ollama 服务。

sudo systemctl start ollama3. 设置开机自启:

如果需要服务器重启后 Ollama 服务能够自动启动,可使用以下命令设置开机自启。

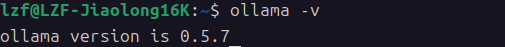

sudo systemctl enable ollama4. 验证 Ollama 是否安装成功:

在终端中输入ollama -v,若输出版本信息,则说明 Ollama 已成功安装。

四、使用 Ollama

1. 拉取模型:

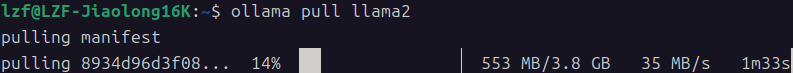

Ollama 提供了多种语言模型可供使用。可使用以下命令拉取模型。例如,拉取llama2模型。

ollama pull llama2

2. 启动模型:

拉取模型后,可使用以下命令启动模型并进行交互。

ollama run llama2

此时,可在终端中输入问题,模型将返回相应的回答。